人工智能进入面相领域,面部算法分析能否窥视你的内心?

目前甚嚣尘上的研究认为人的头部和脸部形状能够揭示性格特征,与被遗弃已久的面相伪科学有着令人不安的相似性。现在,计算机更擅长于扫描人体生理学上微小的细节,现代研究人员由此认为,他们所得出的推论更加可靠。而在另一面,批评者认为这纯属无稽之谈。他们指出,几乎没有证据表明,外在的身体特征或其他特征能够预测行为。在任何情况下,机器只会学习我们教给它们的东西,但人类是一个糟糕的老师,因为我们身上普遍存在公开的或微妙而不被承认的偏见和偏颇的思维。

英国护照办公室的一名志愿者正在扫描生物识别登记卡

你的眉毛形状是否出卖了你的性格?

上学第一天,一个孩子面朝与学校电脑相连的数码相机。快速扫描后,这台机器报告说,这个孩子的面部轮廓预示了她可能具有的攻击性,于是她被标记,此后在学校里受到额外的监督。不远处,另一个人工智能筛查系统扫描了一个男人的面庞,它从他的眉毛形状推断出他可能性格内向,所以他错失了销售工作的机会。与此同时,整形外科医生淹没在无数的手术要求中,人们渴望一张没有表现出任何“坏”特征的“完美”面孔。

一些学者警告说,由于大数据的崛起和机器学习的进步,这种反乌托邦的噩梦可能并不牵强,更令人担忧的是,目前甚嚣尘上的研究认为人的头部和脸部形状能够揭示性格特征,与被遗弃已久的面相伪科学有着令人不安的相似性。现在,计算机更擅长于扫描人体生理学上微小的细节,现代研究人员由此认为,他们所得出的推论更加可靠。而在另一面,批评者认为这纯属无稽之谈。他们指出,几乎没有证据表明,外在的身体特征或其他特征能够预测行为。在任何情况下,机器只会学习我们教给它们的东西,但人类是一个糟糕的老师,因为我们身上普遍存在公开的或微妙而不被承认的偏见和偏颇的思维。

但研究仍在继续。

就在一年前,麦克马斯特大学工程学教授武筱林和上海交通大学的张希在http://arXiv.org(一家广受欢迎的在线知识库,用于发表不同研究阶段的未审核科学论文)上联合发表的论文指出,计算机可能只需根据照片扫描就能预测谁是被定罪的犯人。(该研究已被删除,但作者在该网发表了对批评者的回应。)另一项研究表明,机器学习可以用来推断女性的性格特征,她们的照片被标上不同的词语——比如妖艳的和甜美的,或者可爱的和浮夸的——这项研究是一群年轻的中国男人做出的。

虽然该文摘要指出,该算法只是在学习和聚合,然后反刍(regurgitating)人类的感知,很容易出错,但是作者还是表示:“我们的经验证据指向了训练机器学习算法的可能性,比如使用人脸图像预测人格特征和行为倾向。”

9月初,斯坦福大学的迈克尔·科辛斯基(Michal Kosinski)和王轶伦发布了一项研究的预稿,报告表明,利用约会网站上的照片可能检测出一个人是否是同性恋。这篇论文被提交给声名卓著的《人格与社会心理学杂志》(Journal of Personality and Social Psychology)并被该杂志接受,尽管今年秋天,为了回应公众的强烈抗议,杂志编辑决定重审这篇论文,包括所谓的伦理评审。

目前所有的争议研究,它们的基本假设并不是什么新鲜事儿。

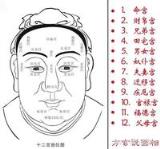

面相学的起源可以追溯到古代的美索不达米亚,但直到19世纪中期意大利犯罪学家切萨雷·龙勃罗梭(Cesare Lombroso)才打算用它来检测犯罪行为。龙勃罗梭相信,可以通过面部结构的异常情况来识别罪犯——基本上,他们都是“退化”的,会有一些“返祖”特征,比如倾斜的前额和不对称的面部。他的观点在二战后被抛弃,但仍有一些科学家继续寻找身体和思想之间的联系。

许多这些研究与人类的感知有关——我们是否因所见不同而所感不同,即便这种知觉是不准确的。另一些人则寻找人类之间的形态差异,搜寻诸如攻击性、内向或同性恋等特征的迹象。例如,有几项研究表明,脸部的长宽比——这项指标与睾酮激素有关——可能提供线索判断一个人的攻击性倾向。

但是,随着海量数据和先进计算能力的兴起,一些科学家和心理学家开始相信“神经网络”——机器学习中使用的网络系统——能够比过去用更少的偏见来分析生理和心理特征。以往的科学家只能向本科生展示几十个人的照片,测量少数几个因素,而互联网则打开了无穷无尽的输入宝库。面部识别软件可以测量成千上万,乃至数百万人的网络照片,从而获得更多的——希望也是更好的——数据。

支持者们说,这些信息被输入到可以探测最细微模式的机器上,而机器能够捕捉到人眼无法识别的物理差异。

这听起来激动人心。但对于很多批评者而言,隐藏在数学算法表象之下的,只是一种普通而古老的拙劣科学——现在用的是算法,而不是一个人拿着卡尺测量鼻子和眉毛。他们还引述了无数关于道德、隐私和各种有意无意潜在偏见的担忧,害怕这些算法可能在某一天通过一次扫描就决定我们的命运。

面部识别测量的可能仅仅是社会心理感知

虽然很少有科学家能够否认,身体特征有时能够揭示人体内的硬指标,比如睾酮激素与人脸之间的联系,但从这些观察中能够得出的推论微乎其微。格拉斯哥大学神经科学与心理学研究所面部研究实验室负责人丽莎·德布林(Lisa DeBruine)将自己描述成一个进化心理学家,但她并不回避这个领域的缺陷。至于面部长宽比,她说:“这一领域的研究实在是一团糟。”很大程度上是因为人工或计算机测量的前后不一致性,例如从下巴到眉毛或者颧骨到颧骨的距离。

德布林是科辛斯基研究的众多批评者之一,该研究试图训练一台计算机识别谁是同性恋,谁是异性恋,所用的数据是一家约会网站上的照片,在这个网站上,用户清楚地标明他们的性取向和偏好。科辛斯基声称,给定两张新的照片,一张是异性恋,一张是同性恋,计算机能够以很高的准确率猜测哪一个是同性恋。他还用计算机从未接触过的脸书照片测试这个算法,结果似乎是正确的——至少能准确判别谁是同性恋。该算法在识别异性恋上表现没有那么好。

(这听起来可能违反直觉,但这一算法没有采用排除法。更确切说,给定一张照片,在同性恋和异性恋中二选一,同性恋照片判定正确的概率高于异性恋。)

科辛斯基在论文中说,计算机对与产前激素理论(prenatal hormone theory,PHT)相一致的特定面部特征进行零位调整(zeroing),这一理论认为同性恋是在子宫中暴露于不同水平的雄激素。“男同和女同具有不典型的性别面部特征,”这位科学家写道,“正如PHT所预测的那样。”科辛斯基认为,产前激素理论是一种“被广泛接受”的同性恋起源模型。

但是批评者说,科辛斯基的公式有好几个问题,包括各种刻板印象的假设,没有意识到PHT未必像听起来那么可靠,计算机可能在判断同性恋的特征集合之外抓取别的东西。

奥柏林学院社会学副教授格雷戈尔·马特森(Greggor Mattson)说,子宫中的睾酮激素暴露导致同性恋的想法,一定程度上取决于男同女性化和女同男性化的刻板印象。他在一封电子邮件中说:“他的工作成果强化了陈腐的刻板印象和糟糕的性科学。”他指出,数据科学本身并不是问题,问题是如何解释数据。

马里兰大学社会学教授菲利普·科恩(Philip N. Cohen)在一篇博客文章中指出,科辛斯基的工作与PHT并不矛盾,但也没有提供太多的支持。范德比尔特大学的人类学家卡维尔·比约克-詹姆斯(Carwil Bjork-James)指出,PHT的争议性远大于科辛斯基所认为的。

根据比约克-詹姆斯的说法,科辛斯基的主要问题是未能认识到各种混杂的因素。比如,约会网站上的照片可能不具有代表性。“人们会挑选照片,”他说,“如果我要在同性约会网站上放点东西,我会选择最"同志"的照片。”是否是同性恋以及如何传达这一信息,是一个自我呈现与他人感知之间复杂的相互作用。但是科辛斯基和他的团队“直接跳到了产前激素失衡理论”。

科辛斯基坚持,这项测试并没有测试PHT,而仅仅是测试一个算法是否可以用来“找出”同性恋,而他想要警告人们存在这样的技术。他说:“看!如果一个人、一个国家或者一个机构想要"找出"某类人,这就是个很好的筛查工具。”

然而,即便是科辛斯基也承认,计算机可能抓取了一些除不可变的面部特征之外的东西。例如,他的算法假定同性恋更有可能戴眼镜。科辛斯基说:“很多人都疑惑,为什么戴眼镜的面孔被算法认为更有可能是同性恋,可能还有其他的面部特征与戴眼镜有关。”

武筱林的批评者也对识别罪犯的计算机算法的训练数据提出了类似的问题。他的研究使用罪犯的识别照片和来自网络搜索的非罪犯照片集。但是华盛顿大学进化生物学教授卡尔·伯格斯特龙(Carl Bergstrom)和该校信息学院助理教授杰文·韦斯特(Jevin West)评价武筱林的工作时说,人工智能算法可能在表情(expression)上发现了细微的差别。(武筱林在给批评者的公开信中承认了这一点。)

尽管如此,即便照片中的罪犯和被输入计算机的非罪犯之间确实存在生理上的差异,那也可能只是揭露了中国刑事审判体系中更多的刻板印象。批评者还指出,这些罪犯的照片来源缺乏透明度。(武筱林在研究中说,一些照片来自中国的警察部门,但他签署了保密协议。)

比约克-詹姆斯指出,武筱林的后续研究也有类似的问题。这可能对中国男性的刻板印象进行了很好的研究,但对女性的行为或个性一无所涉。

在一封电子邮件中,武筱林似乎表示同意:“我们的研究仅仅是关于对脸部的社会心理感知,而人工智能算法预测的这些感知本身的有效性如何,我们的研究没有任何结论。”

商业公司也在进入古老的面相学领域

科学家并非唯一一批进入面相学的人。一家以色列创业公司Faception的广告宣传说,他们的面部识别技术能够通过某些特征识别恋童癖和恐怖分子。总部位于波士顿的Affectiva公司开发了一个面部识别系统,自称可以帮助广告商检测情绪。

麻省理工学院博士生、乔治敦大学隐私与技术中心技术专家乔纳森·弗兰克(Jonathan Frankle)说,我们经常不知道这些算法是如何工作的。与普通代码不同的是,神经网络包含的节点是相互关联的,进程是并行发生的。一个神经网络不只是按顺序执行一组指令;相反,节点之间相互交谈,互相给予反馈。实在没有任何办法来追踪它如何做出决定——我们不能只看一行代码或者一个子例程(subroutine),它实际上是一个黑箱。

这意味着我们根本搞不清楚,我们设计的算法和人工智能引擎是否正在抓取我们认为它们在抓取的特征,科辛斯基的研究反映了这一点:当它试图合成一个男同性恋标准脸,它是戴眼镜的,但是没有证据表明同性恋的视力问题比人口平均水平更加严重。科辛斯基说,这可能是男同性恋的时尚选择,但是这削弱了同性恋具有特异脸部形态的论点。

我们不知道人工智能正在做什么,尤其令人担忧的情况是,一家像Faception这样的创业公司做广告说它可以检测社会威胁,而出于保守商业秘密的需要,这家公司的首席执行官沙伊·吉尔伯(Shai Gilboa)对如何设计算法以及他们使用何种数据来训练算法这些问题语焉不详。但他却强调,Faception的系统基于可靠的研究,而且没有偏见。“从伦理的角度来说,这是非常重要的,”他说,“我们反复证明,我们并没有把肤色或种族作为衡量标准。”

与此同时,Affectiva并没有说它可以从面部结构中发现任何关于先天人格特征之类的东西,而只能检测一个人的情绪状态。首席执行官拉娜·卡柳比(Rana el Kaliouby)进一步补充道,她的公司用来自不同国家的对象训练人工智能,并将这部分人口作为比较的基准点(例如,在中国或巴西运行的软件将使用来自该国人口的图片进行训练)。

卡柳比说,这种方法能够避免忽略人们情感表达背后的文化差异。最重要的是,她说,Affectiva团队对人工智能进行审问,以确定在解读面部表情的时候它们知道自己抓取了什么。

人们总是倾向于相信有数学支撑的东西

在所有的技术担忧中,批评者还关注伦理问题。科辛斯基研究使用的照片未经许可,他没有与任何同性恋组织有密切合作。(美国最著名的LGBDQ权利组织之一GLAAD与人权运动组织发表了联合声明,指责该研究的方法。)在武筱林的案例中,罪犯照片由中国警察部门提供,但他不能说出是什么单位。这两项研究都引起了人们的担忧,如果一些政府或私人企业从一开始就决定使用这些具有歧视意图的技术,将会发生什么?

而批评者认为,被建构起来的面部算法分析实际上不过是一种脆弱的、文化构建的假设,这是最令人担忧的。德布林在一封电子邮件中说:“社会心理学也有严肃的问题,它往往受到英语母语使用者、异性恋者、白人意识的主导,这无疑推动了这类研究。我无法想象,如果整个渠道的某些节点(同事、伦理委员会、编辑、评论家等)有更多不同背景的人员占据了有影响力的位置,科辛斯基的研究还能走得现在这么远。”

在某种意义上,弗兰克庆幸这类研究出现在公开的文献中。他说:“我宁愿它是由学术研究者公开的,而不是由私人公司开发并卖给警察机构的。”

乔治敦大学隐私与技术中心助理克莱尔·加维(Clare Garvie)说,这些研究中的问题并不是总是科学本身,尽管它是可质疑的,而是人类倾向于相信计算机——或者听起来有数学支撑的东西。她说:“这种工具决定了谁能进入一个国家或者得到一份工作。如果科辛斯基的成果或者类似的东西能够在权威的期刊上发表,那么Faception的主张就可能得到支持。然而,Faception的营销材料表示可以用针织帽和山羊胡来识别恐怖分子,这并不能让加维感到安心。

在吉尔伯看来,网络图片仅仅是一个设计决定,他还提供了几项关于面部匀称和人格之间关系的研究,其中一些关注营销和广告,另一些涵盖人格类型的地理分布,没有一项研究直接支持Faception的主张。

解决这些问题并非绝无可能,而且大多数接受采访的专家都同意,这样的研究可以做得更好,比如美国圣母大学计算机科学的助理教授沃尔特·斯切尔(Walter Scheirer)说,计算机科学领域人才多元化或许有所帮助,计算机科学和其他学科之间应该进行更广泛的对话。

纽约州立大学布法罗分校的传播学教授马克·弗兰克(Mark Frank)补充道,多一点谦逊和怀疑也会有所帮助,他表示:”计算机科学对行为事务的理解是迷人的——这是我要用的词。”他们所测量的现象有如此之多的复杂性,而身体和行为之间的任何联系都比这些初步研究表明的东西更加微妙,也受到更多混杂因素的影响。

进化生物学家伯格斯特龙认为,所有这些研究都源于长期存在的、在身体中寻找编码的心理学的渴望——即便可能是错误的。他说:“我确实认为,这种想法在人类思维中根深蒂固,即我们的外表能够反映我们内在的思想与道德。而它会随着时间的推移不断重生,其源头甚至可以追溯到几千年前。”

关注壹看板,可视化数据分析工具助力您业务增长!